研究成果,および研究室所属の学部生による実習制作作品に関する動画を Youtube で公開しています.各画像をクリックすると Youtube で動画を再生します.

3次元センシング技術 画像センシング技術 ヒューマンセンシング技術 その他の動画

2009年度 2010年度 2011年度 2012年度 2013年度

2014年度 2015年度 2016年度 2017年度 2018年度

2019年度 2020年度 2021年度

新着動画

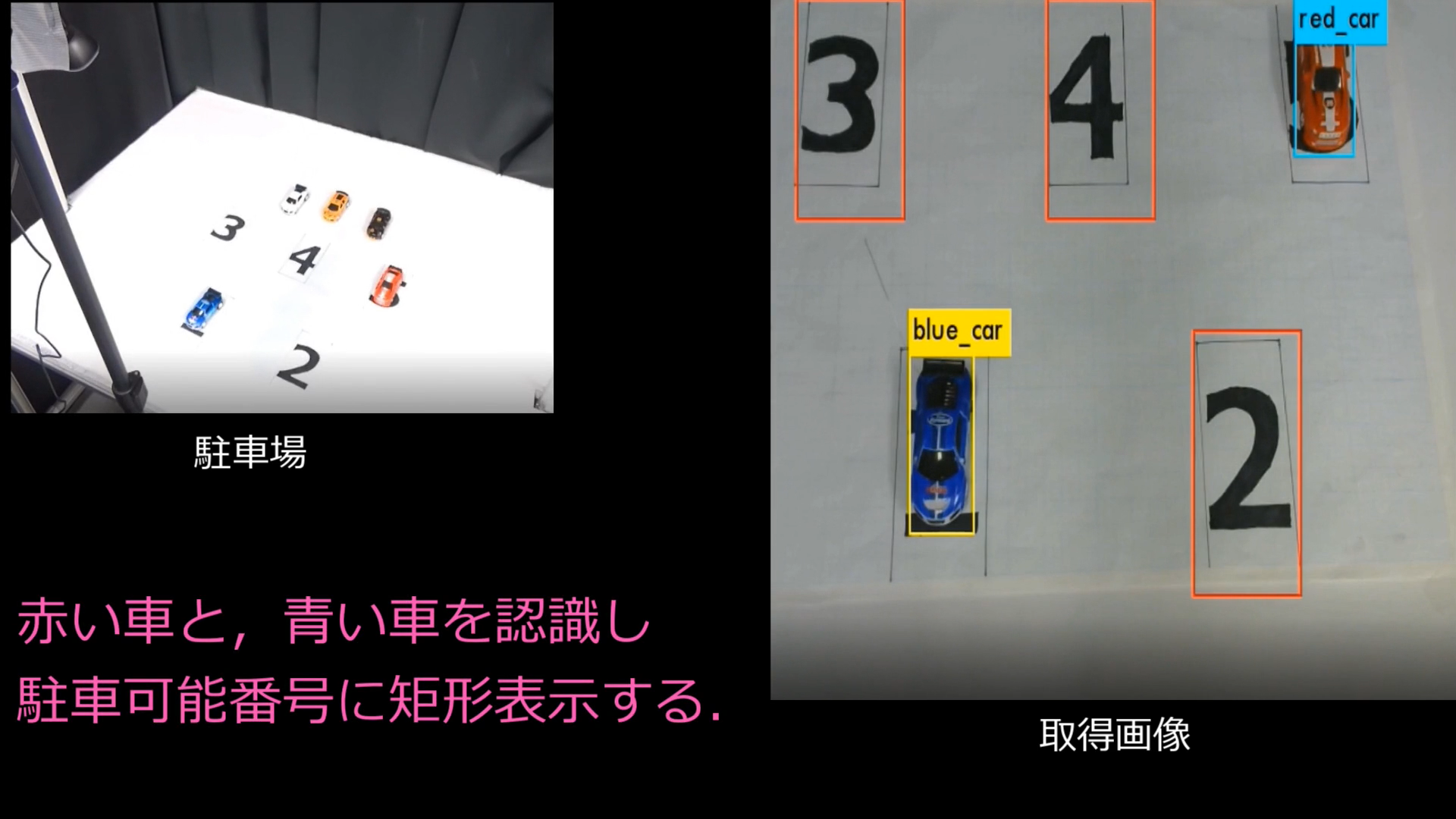

| CEATEC2024 2D画像センシング |

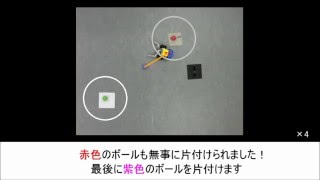

CEATEC2024 3D物体認識・ロボット |

CEATEC2024 ヒューマンセンシング |

|

|

|

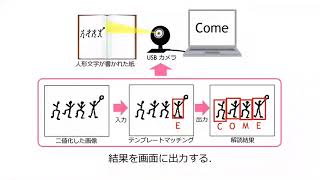

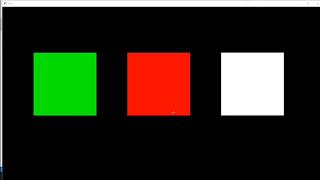

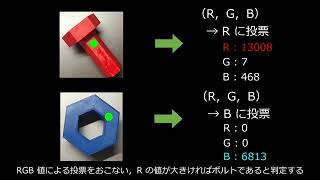

| CEATEC2024で展示した2D画像センシングに関する研究成果の紹介動画です. | CEATEC2024で展示した3D物体認識・ロボットに関する研究成果の紹介動画です. | CEATEC2024で展示したヒューマンセンシングに関する研究成果の紹介動画です. |

研究成果デモ動画

橋本・秋月研究室では,3次元センシング,画像センシング,ヒューマンセンシングの3つの研究領域において,先進的かつ実用的な研究を行っています.

ここでは,学会発表等で紹介したデモや実験に関する動画を公開しています.

3次元センシング技術

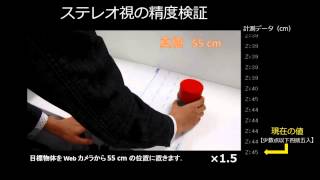

画像センシング技術

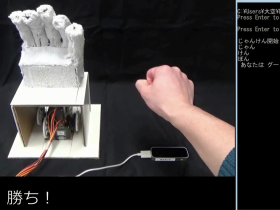

ヒューマンセンシング技術

| 距離画像シーケンスの分析に基づく ピアノ演奏における運指の自動認識 (J. S. Bach, Menuet) |

距離画像シーケンスの分析に基づく |

|

|

| 学習型ピアノ運指認識手法を,バッハ「メヌエット」に適用した.青枠は認識成功,赤枠は失敗を示しています. |

ボトムアップ型運指認識手法を「かっこう」に適用してみました.◯印は認識成功,×印は失敗を示しています. |

その他の動画

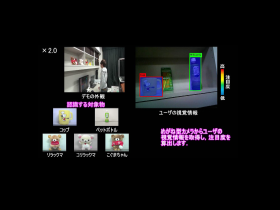

| 橋本研究室1分間紹介(物体検出技術) |

|

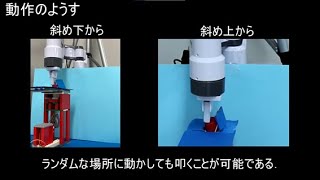

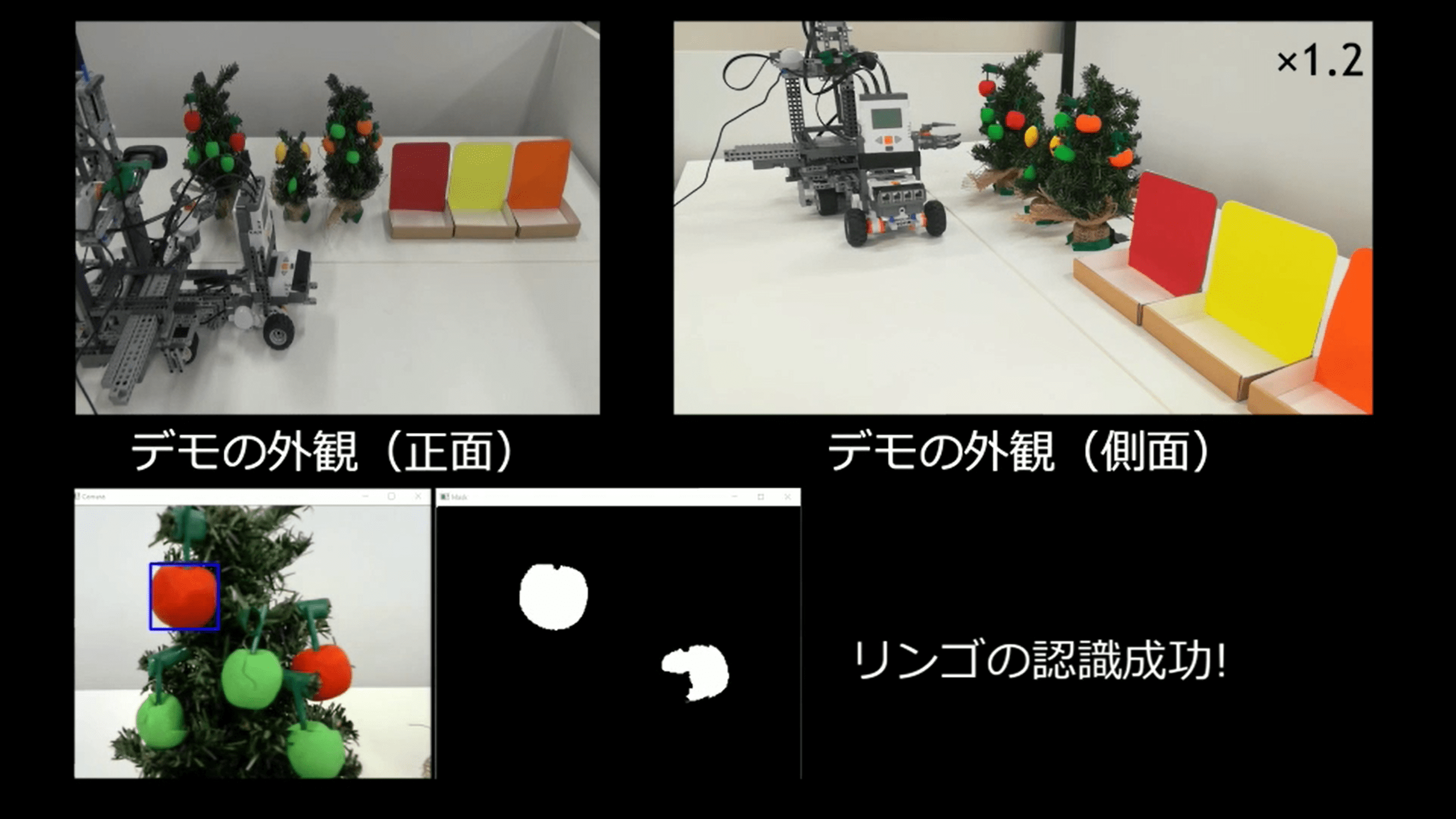

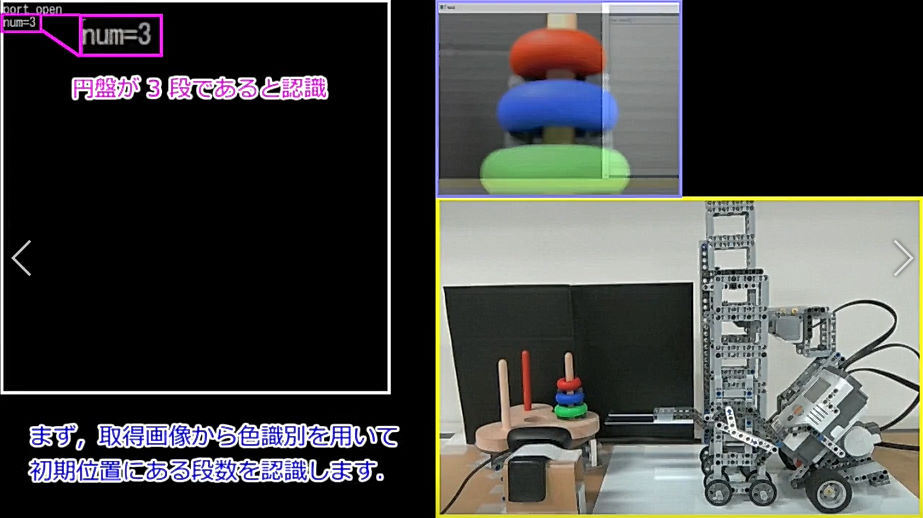

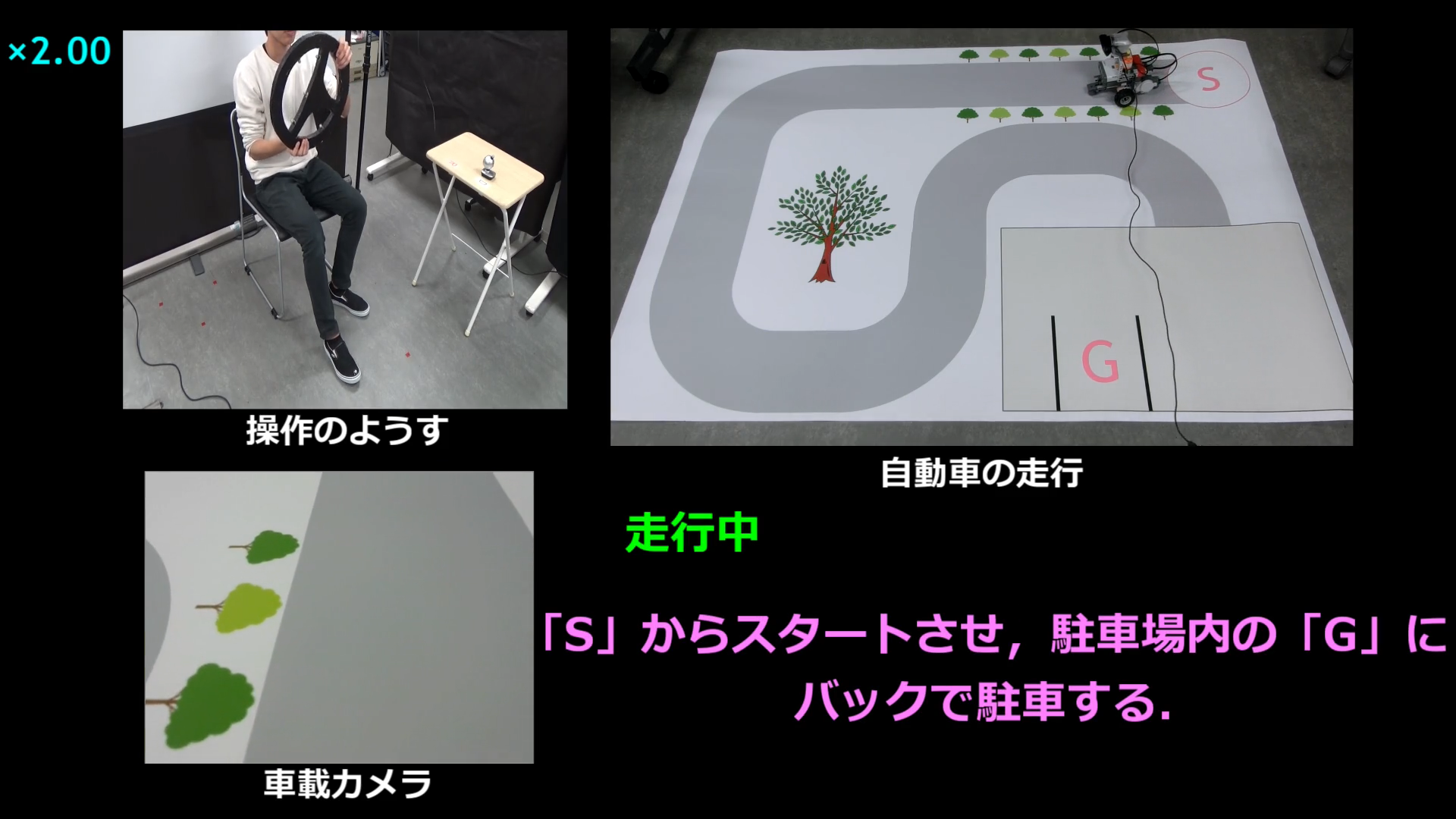

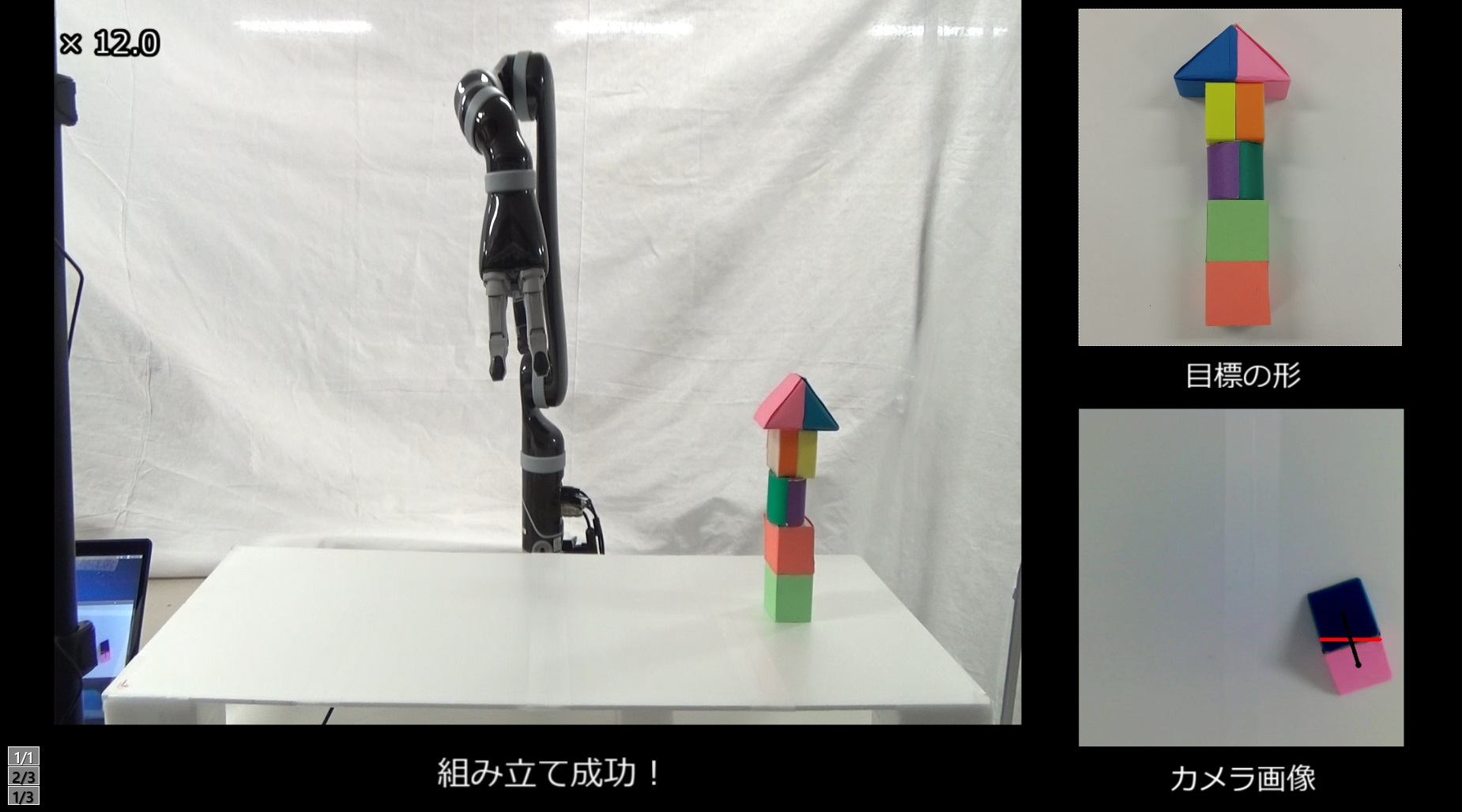

| 中京大学橋本研における物体検出に関する研究成果です.ロボットセンシングに関する技術を3種類ご紹介します. |

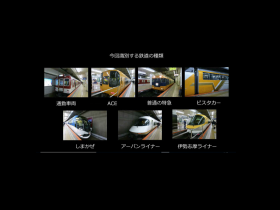

| CEATEC2024 2D画像センシング |

CEATEC2024 3D物体認識・ロボット |

CEATEC2024 ヒューマンセンシング |

|

|

|

| CEATEC2024で展示した2D画像センシングに関する研究成果の紹介動画です. | CEATEC2024で展示した3D物体認識・ロボットに関する研究成果の紹介動画です. | CEATEC2024で展示したヒューマンセンシングに関する研究成果の紹介動画です. |

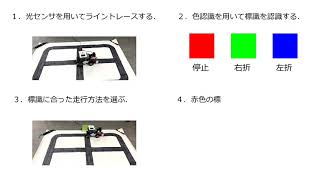

学部生による実習制作作品

橋本・秋月研究室では,研究室に配属された学部生に対して,ロボット制御や画像処理,情報処理全般に関する 基礎および応用教育を実施しています.ここでは,学部生(主に2年生)が実習授業で制作した数々の作品 を公開しています.

2020年度

2019年度

2018年度

2017年度

2016年度

2015年度

2014年度

2013年度

2012年度

2011年度

| 視線検出による関心度測定 | CPTMを用いた 超高速カメラぶれ補正 |

ODEを用いた リアルなロボットアームの実現とシミュレーション |

|

|

|

|

ユーザの視線を検出し,連続注視時間による関心度評価グラフを表示します. |

高速テンプレートマッチング(CPTM)を用いた同画像のぶれ補正を実現しました. |

ODE(Open Dynamic Engine)を用いたロボットアームMELFAの動作シミュレータを作成しました. |

2010年度

2009年度

Copyright(C)2010 – Hashimoto Lab., All rights reserved

-300x169.png)

-300x201.png)

-300x169.jpg)

-300x169.jpg)

-300x169.png)

-300x169.jpg)

-300x169.png)

-300x188.png)

-300x169.png)

-300x169.png)

-300x167.png)